Ostatnio media donoszą, że wraz z wydaniem najnowszej wersji sztucznej inteligencji GPT-4, jej twórcy obawiają się zalewu dezinformacji na dużą skalę.

Co więcej, Elon Musk ostrzega, że sztuczna inteligencja jest bardziej niebezpieczna niż broń nuklearna. Zdaniem twórców ludzkość nie ma zbyt wiele czasu, aby przejąć pełną kontrolę nad technologią.

Co to jest GPT-4

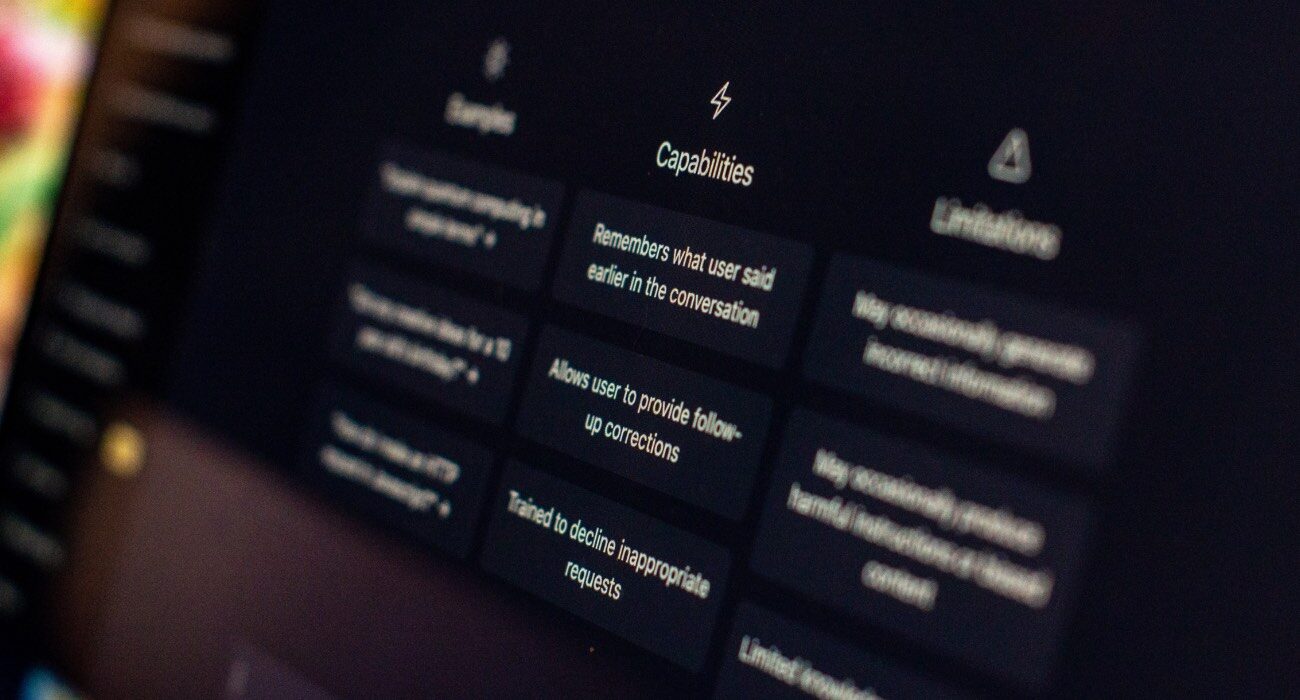

GPT-4 to nowy multimodalny system sztucznej inteligencji, który pozwala na odbieranie i odtwarzanie informacji w postaci obrazów, plików audio i wideo, w przeciwieństwie do poprzedniej wersji, która opierała się jedynie na poleceń tekstowych. Według CEO OpenAI i jednego z deweloperów GPT, Sama Altmana, najnowszy model tworzy informacje w oparciu nie tylko o proces zapamiętywania, ale także wykorzystuje dedukcję, co może prowadzić do dziwnych rezultatów. Niestety, efektem ubocznym tej technologii jest „halucynacja” – sztuczna inteligencja z przekonaniem stwierdza fakty, które w rzeczywistości są fałszywe.

Co więcej, GPT-4 jest w stanie napisać kod komputerowy, który może być wykorzystany przez hakerów do poważnych cyberataków. Wszystko to powoduje, że twórcy narzędzia obawiają się, że może być ono wykorzystane do szerzenia dezinformacji i manipulacji na dużą skalę. Sam Altman wyjaśnia, że narzędzie jest w dużym stopniu kontrolowane przez człowieka, ale istnieje ryzyko, że inni ludzie usuną wprowadzone przez nich ograniczenia bezpieczeństwa. W związku z tym, twórcy GPT wierzą, że społeczeństwo ma ograniczoną ilość czasu, aby dowiedzieć się, jak na to zareagować, uregulować i sobie z tym poradzić.

Zagrożenia związane z GPT-4

Nie ma wątpliwości, że sztuczna inteligencja ma ogromny potencjał i może być wykorzystywana do pozytywnych celów, ale jednocześnie wiążą się z nią poważne zagrożenia. Dyrektor generalny Tesli, Elon Musk, wielokrotnie ostrzegał, że sztuczna inteligencja lub AGI (sztuczna ogólna inteligencja) jest bardziej niebezpieczna niż broń nuklearna. Dlatego też, ważne jest, aby ludzkość przestała lekceważyć ryzyka związane z rozwojem sztucznej inteligencji i działała w kierunku ograniczenia zagrożeń, jakie ona niesie.

Dlatego też, w miarę jak sztuczna inteligencja staje się coraz bardziej zaawansowana, niezbędne są bardziej rygorystyczne przepisy i zasady, które pozwolą na kontrolowanie jej działania. Konieczne są również kampanie edukacyjne, które pomogą społeczeństwu zrozumieć zagrożenia związane z sztuczną inteligencją i jak się przed nimi bronić. W ten sposób, będziemy mogli maksymalnie wykorzystać zalety sztucznej inteligencji, jednocześnie minimalizując jej potencjalne ryzyka.

Wydaje się, że na obecnym etapie rozwoju sztucznej inteligencji, obawy związane z jej wykorzystaniem są uzasadnione. Dlatego też, ważne jest, abyśmy działa w sposób odpowiedzialny i w duchu ostrożności, aby zminimalizować ryzyko związane z jej wykorzystaniem. W przeciwnym razie, konsekwencje mogą być bardzo poważne i wpłynąć na nasze życie w sposób, którego nie jesteśmy w stanie sobie wyobrazić.

A co Wy o tym myślicie? Dajcie znać w komentarzach.