Apple postanowiło wycofać się z planów wprowadzenia systemu wykrywania materiałów zawierających wykorzystywanie seksualne dzieci (CSAM) na swojej platformie iCloud.

Ostateczne stanowisko korporacji w tej kwestii zostało przedstawione w odpowiedzi na apel inicjatywy Heat Initiative, grupy zajmującej się bezpieczeństwem dzieci. Apple uznało, że wprowadzenie takiej technologii może narazić na szwank prywatność użytkowników i stworzyć nowe wektory ataku dla cyberprzestępców.

Erik Neuenschwander, dyrektor ds. prywatności użytkowników i bezpieczeństwa dzieci w Apple, podkreślił, że firma podejmuje wszelkie starania, aby chronić dzieci przed wykorzystywaniem. Zdaniem korporacji, choć walka z materiałami zawierającymi wykorzystywanie seksualne dzieci jest absolutnie konieczna, technologia wykorzystywana do tego celu nie może podważać ogólnej prywatności cyfrowej. Apple prowadziło szerokie konsultacje z badaczami w dziedzinie prywatności i bezpieczeństwa, grupami broniącymi praw cyfrowych oraz ekspertami od bezpieczeństwa dzieci. Wnioski były jednoznaczne: mechanizm skanowania CSAM w chmurze iCloud mógłby stworzyć więcej problemów, niż by rozwiązał.

Neuenschwander wskazał na kilka kluczowych zagrożeń, w tym możliwość wykorzystania systemu przez złodziei danych. Jakakolwiek forma masowej inwigilacji może otworzyć furtkę do nadużyć, również ze strony rządów. Obawy te są jeszcze bardziej aktualne w kontekście rządowych inicjatyw, jak np. planowane przez Wielką Brytanię zmiany w zakresie regulacji dotyczących szyfrowania i prywatności danych. Podobne środki mogą w rzeczywistości zmusić firmy technologiczne do porzucenia kluczowych mechanizmów zabezpieczeń, co z kolei mogłoby podważyć zaufanie użytkowników do tych platform.

Warto również wspomnieć, że wcześniejsze plany Apple spotkały się z krytyką ze strony różnych organizacji i ekspertów, w tym Electronic Frontier Foundation (EFF), specjalistów ds. bezpieczeństwa i badaczy akademickich. Nawet niektórzy pracownicy Apple wyrazili swoje obawy, zwracając uwagę na potencjalne niezamierzone konsekwencje takiego systemu.

Apple miało pierwotnie zamiar wdrożyć tę funkcję jako część aktualizacji iOS 15 i iPadOS 15 w 2021 roku. Niemniej jednak, po szerokim przeglądzie opinii, zarówno od klientów, jak i ekspertów, korporacja postanowiła odroczyć te plany na nieokreślony czas.

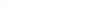

W sytuacji, w której globalna debata na temat prywatności online i bezpieczeństwa dzieci nadal się rozwija, decyzja Apple wydaje się być próbą znalezienia równowagi pomiędzy tymi dwoma krytycznymi problemami. Jak zauważa firma, inwestuje ona w inne mechanizmy i narzędzia mające na celu zapewnienie bezpieczeństwa dzieci, takie jak funkcja Communication Safety w iOS oraz zasoby edukacyjne w asystencie głosowym Siri.

Wszystko to pokazuje, jak skomplikowaną i wielowymiarową kwestią jest walka z wykorzystywaniem seksualnym dzieci w erze cyfrowej, gdy każda decyzja niesie ze sobą szereg konsekwencji zarówno pożądanych, jak i niepożądanych.