Międzynarodowa koalicja ponad 90 grup politycznych i praw człowieka wydała list otwarty wzywający Apple do porzucenia projektu analizy zdjęć CSAM.

Grupa twierdzi, że cele tego systemu nie uzasadniają tak dużej ingerencji w prywatność użytkowników:

Chociaż system wykrywania CSAM ma na celu ochronę dzieci i ograniczenie rozpowszechniania pornografii dziecięcej, jesteśmy zaniepokojeni, że technologie te są wykorzystywane do cenzurowania komunikacji, zagrażają prywatności i bezpieczeństwu ludzi na całym świecie oraz mają katastrofalne skutki dla wielu dzieci.

Sygnatariusze listu wysłanego do Apple obawiają się, że system skanowania CSAM w urządzeniach Apple może być wykorzystywany przez niektóre kraje o różnych systemach prawnych do wyszukiwania treści politycznych i innych rzeczy.

Ponadto w liście wezwano Apple do rezygnacji z planowanych zmian w iMessage na kontach rodzinnych, które będą identyfikować i zaciemniać nagość w wiadomościach od dzieci, umożliwiając im oglądanie zdjęć tylko po powiadomieniu rodziców.

Skanowanie SCAM

Strony uważają, że może to pogorszyć relacje dzieci z rodzicami, a także uniemożliwić wykorzystywanie takich obrazów do celów edukacyjnych. Organizacja non-profit Center for Democracy & Technology (CDT) obawia się, że szanse na to, że CSAM zapewni politykom tylne drzwi w celu przeprowadzenia represji, są zbyt duże.

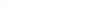

Apple wielokrotnie wyjaśniało, że skanowanie nie będzie skanować zdjęć wszystkich ludzi na ich iPhone’ach, ale tylko tych, których hashe pasują do obrazów pornografii dziecięcej w bazie danych. Większość grup praw człowieka, które podpisały list, znajduje się w Indiach, Meksyku, Niemczech, Argentynie, Ghanie i Tanzanii.

Dodatkowo Apple potwierdziło, że wykrywanie pornografii dziecięcej dotyczy tylko zdjęć przechowywanych w iCloud Photos. Możliwe jest zatem wyłączenie skanowania zdjęć przez Apple.

Jak wyłączyć skanowanie zdjęć przez Apple

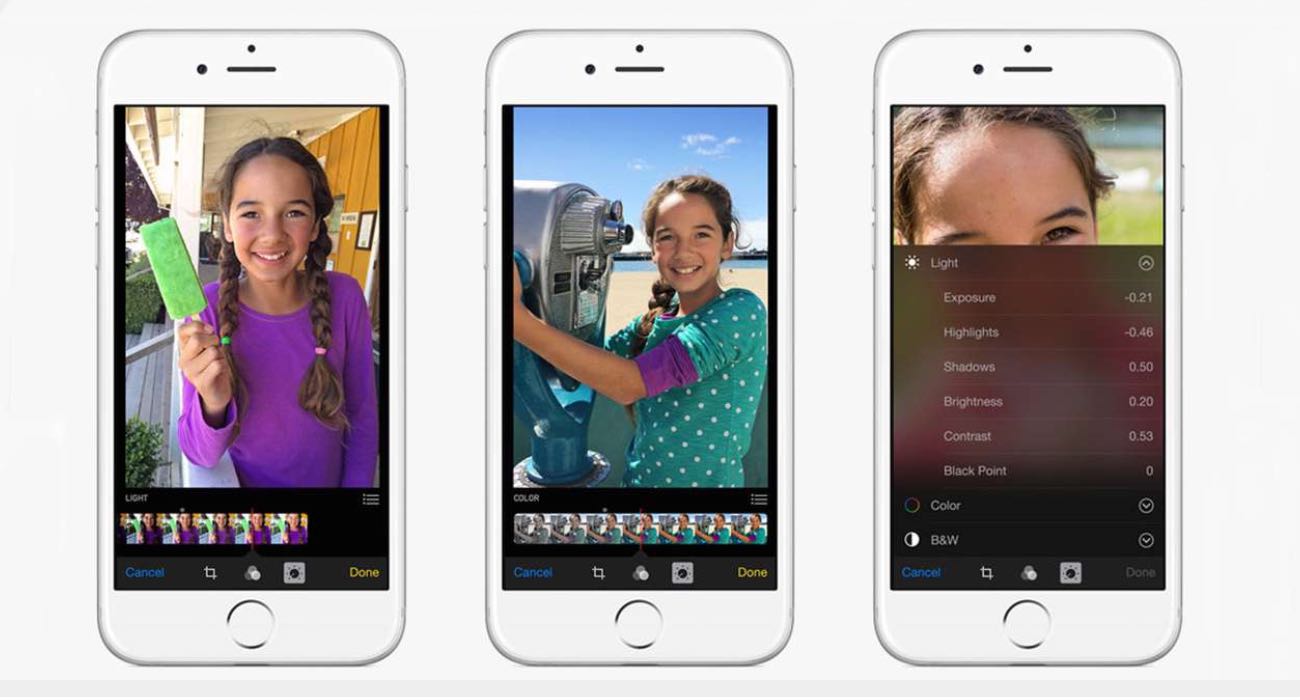

W związku z tym, że skanowane będą tylko zdjęcia przesyłane do chmury, można łatwo uniemożliwić firmie Apple skanowanie. Jak?Wystarczy wykonać poniższe czynności:

- Przejdź do Ustawienia i kliknij swoje imię;

- Otwórz iCloud i kliknij zakładkę Zdjęcia;

- W oknie, które zostanie otwarte, wyłącz element Zdjęcia iCloud;

- Kliknij “Usuń z iPhone’a” i potwierdź usunięcie.

Firma oświadczyła również, że w żadnych okolicznościach nie będzie udostępniać technologii NeuralHash i CSAM osobom trzecim.